关于DeepSeek的几点思考

关于这几天很火的DeepSeek,我们(ArchermanCapital)做了一些研究和思考,和大家分享,enjoy!灰色部分是技术细节,不感兴趣的可略过。几个事实1)DeepSeek不是套壳不是蒸馏美国的大模型。虽然中国有些大模型是套壳和蒸馏的,但DeepSeek不是。2)核心架构还是基于Transformer,deepseek在架构、工程设计上进行了创新和工艺提升,实现效率优化。架构上,采用了混合专家模型(MoE)、多头潜注意力(MLA)、多令牌预测(MTP)、长链式推理(CoT)、DualPipe算法等设计,并进行了依赖强化学习(RL)而不加入监督微调(SFT)的训练尝试。工程上,在数据...

相关推荐

-

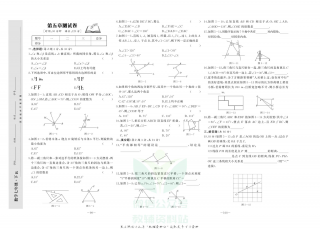

中华题王七年级下册历史人教版测试卷

2025-09-23 999+

2025-09-23 999+ -

中华题王七年级下册生物人教版

2025-09-23 999+

2025-09-23 999+ -

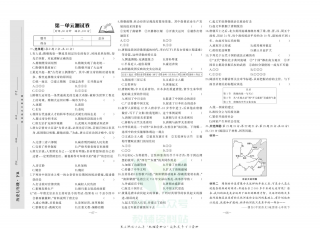

中华题王七年级下册生物人教版测试卷

2025-09-23 999+

2025-09-23 999+ -

中华题王七年级下册数学人教版

2025-09-23 999+

2025-09-23 999+ -

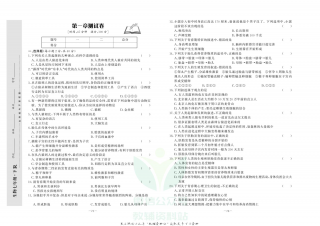

中华题王七年级下册数学人教版测试卷

2025-09-23 999+

2025-09-23 999+ -

中华题王七年级下册英语人教版

2025-09-23 999+

2025-09-23 999+ -

中华题王七年级下册英语人教版测试卷

2025-09-23 999+

2025-09-23 999+ -

中华题王七年级下册语文人教版

2025-09-23 999+

2025-09-23 999+ -

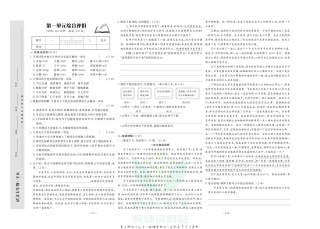

中华题王七年级下册语文人教版测试卷

2025-09-23 999+

2025-09-23 999+ -

点拨训练七年级下册地理晋教版

2025-09-25 999+

2025-09-25 999+

相关内容

-

中华题王七年级下册英语人教版

分类:教育专区

时间:2025-09-23

标签:英语

格式:PDF

价格:1 智慧点

-

中华题王七年级下册英语人教版测试卷

分类:教育专区

时间:2025-09-23

标签:英语

格式:PDF

价格:1 智慧点

-

中华题王七年级下册语文人教版

分类:教育专区

时间:2025-09-23

标签:语文

格式:PDF

价格:1 智慧点

-

中华题王七年级下册语文人教版测试卷

分类:教育专区

时间:2025-09-23

标签:语文

格式:PDF

价格:1 智慧点

-

点拨训练七年级下册地理晋教版

分类:教育专区

时间:2025-09-25

标签:地理

格式:PDF

价格:1 智慧点